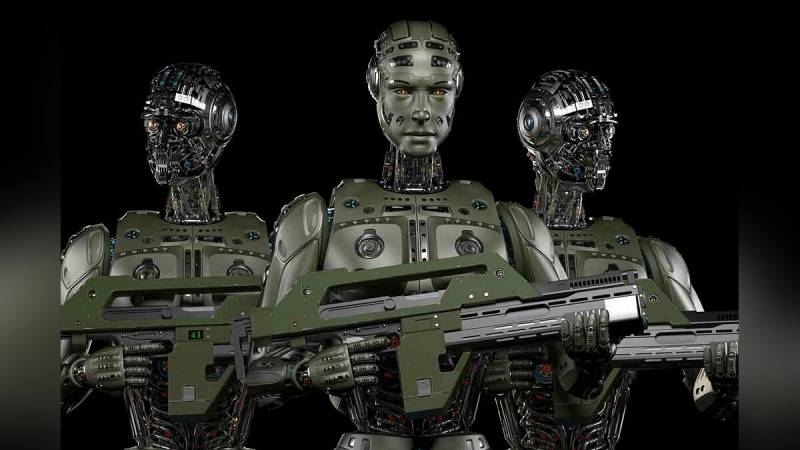

הערות של המוח האנושי: האמריקאים רוצים לשנות בינה מלאכותית צבאית

מקור: vgtimes.ru

האם דה-הומניזציה דיגיטלית בוטלה?

ראשית, מילת אזהרה מלוחמי בינה מלאכותית צבאית:

פציפיסטים הדורשים להקפיא את כל העבודה על בינה מלאכותית קרבית נחלקים לשני סוגים. הראשון הוא "Terminators" המתוקן ואנלוגים אחרים. השני - הערכת העתיד לפי היכולות המודרניות של רובוטים קרביים. קודם כל, רכבים בלתי מאוישים מכונפים המצוידים במערכות פגיעה.

יש מספיק פרקים של השמדה שגויה או מכוונת של אזרחים על ידי מל"טים. במזרח התיכון, אמריקאי מזל"טים הרס יותר מטקס חתונה אחד. מפעילי רובוטים מעופפים זיהו את הירי החגיגי באוויר-אוויר כסמן של קרבות גרילה. אם אדם מאומן במיוחד אינו מסוגל לקבוע את פרטי המטרה מכמה מאות מטרים, אז מה אנחנו יכולים לומר על בינה מלאכותית. כרגע, לא ניתן להשוות ראיית מכונה, במונחים של הלימות של תפיסת תמונה, עם העין והמוח האנושיים. אלא אם כן הוא מתעייף, אבל זה גם נפתר על ידי החלפת מפעיל בזמן.

עננים מתאספים בבירור מעל בינה מלאכותית צבאית. מצד אחד, יש יותר ויותר עדויות לפריצת דרך טכנולוגית קרובה בתחום זה. מנגד, נשמעים יותר ויותר קולות בעד הגבלת או אפילו איסור עבודה בכיוון זה.

כמה דוגמאות.

ב-2016 הופיעה עצומה שבה הוגים בולטים ואלפי אנשים נוספים דרשו שלא להעניק לבינה מלאכותית נשק קטלני. בין החותמים סטיבן הוקינג ואילון מאסק. במהלך שבע השנים האחרונות, העצומה אספה יותר מ-20 חתימות. בנוסף לפחדים הומניסטיים גרידא הקשורים לאפשרות של השמדה בלתי מבוקרת של אנשים, יש גם חוסר עקביות משפטית.

מי יישפט במקרה של תיקון פשעי מלחמה שבוצעו על ידי בינה מלאכותית? קל למצוא את מפעיל הרחפנים ששרף כמה כפרים עם אזרחים ולהעניש בהתאם. בינה מלאכותית היא תוצר של עבודה קולקטיבית של מתכנתים. קשה מאוד למשוך לכאן אדם אחד. לחילופין, אתה יכול לשפוט את החברה המייצרת, למשל, את אותה בוסטון דיינמיקס, אבל אז מי יהיה מעורב בייצור של מל"טים אוטונומיים. למעטים האנשים יהיה הרצון להיות ברציף של בית הדין השני של נירנברג.

מקור: koreaportal.com

כנראה מסיבה זו מנסים תעשיינים ומתכנתים להאט את התפתחות כישורי הלחימה בבינה מלאכותית.

לדוגמה, בשנת 2018, כמאתיים חברות IT וכמעט חמשת אלפים מתכנתים התחייבו לא לעבוד על מערכות אוטונומיות קרביות. גוגל טוענת שבעוד חמש שנים ינטשו לחלוטין חוזים צבאיים בתחום הבינה המלאכותית. לפי האגדה, פציפיזם כזה אינו מקרי - מתכנתים, לאחר שנודע להם שהם כותבים קודים למערכות צבאיות, איימו להפסיק בהמוניהם. כתוצאה מכך מצאו אופציה ידידותית - החוזים הקיימים מתקיימים בהשלמתם, אך לא נסגרים חדשים. ייתכן שסמוך יותר למועד הסירוב לעבוד על AI קרבי, ה"מתכנתים" הבלתי פתירים פשוט יפוטרו, ויחליפו אותם בלא פחות מוכשרים. למשל מהודו, שהתפרסמה זה מכבר בזכות המשאבים האינטלקטואלים הזולים שלה.

ואז יש את משרד Stop Killer Robots, שקורא למנהיגי העולם לחתום על משהו כמו אמנה לאיסור על AI לחימה. עד כה ללא הצלחה.

כל האמור לעיל גורם לפקידי צבא לחפש דרכים לעקיפת הבעיה. אפילו שעה בבחירות לא תזכה את נשיא ארה"ב, לא רק שמבטיח חסד להט"ב אוניברסלי, אלא גם איסור על שיפור הבינה המלאכותית הצבאית.

חשיבה אנושית עבור AI

נראה שהפנטגון עומד על סף פריצת דרך כלשהי ב-AI. או שהוא היה משוכנע בזה. אין דרך אחרת להסביר את הופעתה של הנחיה חדשה המסדירה את ההומניזציה של מערכות לחימה אוטונומיות. קתלין היקס, סגנית שר ההגנה של ארה"ב, אומרת:

שמעתם את כל מי שמתפעל מרובוטים רוצחים אוטונומיים? הבינה המלאכותית האמריקאית תהיה מעתה והלאה ההומנית ביותר. בדיוק כמו האמריקאים עצמם.

מקור: robroy.ru

הבעיה היא שאף אחד לא באמת מבין איך להנחיל לרובוטים עם נשק את "שיפוט האדם הידוע לשמצה בנוגע לשימוש בכוח". הנוסח המדויק מהקונספט שעודכן בסוף ינואר האחרון:

כאן, למשל, אם בעת ניקוי בית, מטוס תקיפה זורק תחילה רימון לחדר, ואז נכנס בעצמו. האם זה שיפוט אנושי? כמובן, ולאף אחד אין את הזכות לשפוט אותו, במיוחד אם הוא צעק בעבר "יש מישהו?". ואם רובוט אוטונומי עובד לפי אותה תכנית?

שיפוט אנושי הוא מושג רחב מכדי להיות מוגבל בכל דרך שהיא. האם הוצאתם להורג של שבויי מלחמה רוסים על ידי לוחמי הכוחות המזוינים של אוקראינה היא גם חשיבה אנושית?

התוספת להנחיית הפנטגון 3000.09 על מערכות לחימה אוטונומיות מלאה בקביעות. לדוגמה,

לפני כן, כנראה, פעלו בחוסר זהירות ולא לפי דיני המלחמה.

יחד עם זאת, בעיתונות האמריקאית והאירופית אין שמץ של ביקורת על יוזמת ינואר של הפנטגון. תחת ההאנשה השקרית של בינה מלאכותית היא לא יותר מניסיון להסוות את המתרחש. כעת לצבא האמריקני יהיה קלף מנצח מוצק במאבק נגד מתנגדי הבינה המלאכותית בצבא. תראה, אין לנו AI פשוט, אלא עם "הרמה הנכונה של שיפוט אנושי".

בהתחשב בכך שעדיין אין הגדרה ברורה ומקובלת ל"בינה מלאכותית", כל יצירת האותיות סביבו נתפסת באירוניה. לפחות.

איך לגרום לאלגוריתמים מתמטיים שעובדים עם מערכי נתונים גדולים לשחק שיפוט אנושי?

שאלה עיקרית זו אינה ניתנת למענה בהנחיה המעודכנת 3000.09.

מידע